PUE=1.0を実現する技術と背景

〔1〕PUE=1.0とはどのような数値なのか?

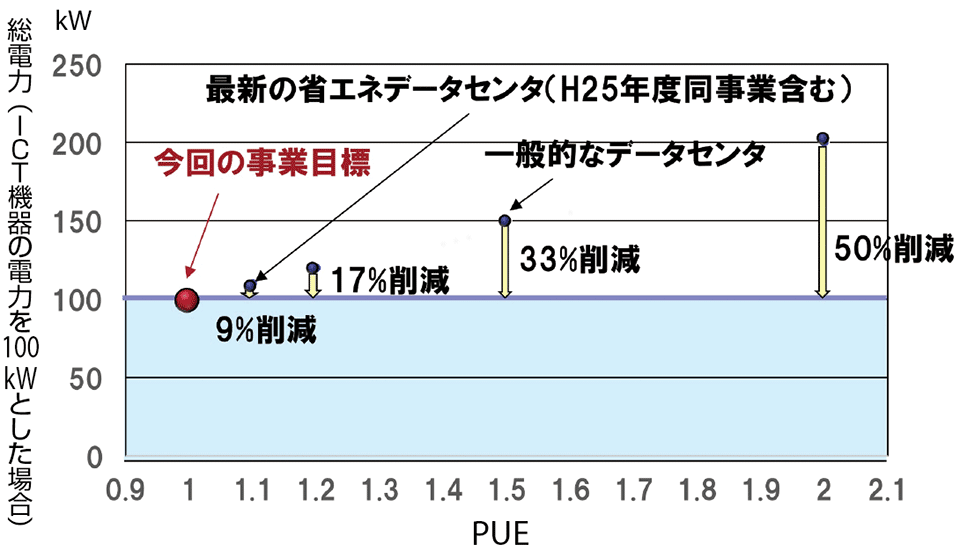

図3は、横軸にPUEを、縦軸にデータセンターの総電力(ICT機器の消費電力を100kWとした場合)を示したものである。図3からわかるように、PUE=1.0は、サーバの消費電力が100kWの場合、データセンター全体の消費電力も100kW(サーバの消費電力となる。サーバ以外の空調機などの消費電力は0kW)ということである。すなわち、

図3 PUE=1.0実現の効果

※図中の17%、33%、50%とは、消費電力の削減量を意味する。

出所 環境省・平成28年度CO2排出削減対策強化誘導型技術開発・実証事業「データセンタの抜本的低炭素化」、2016年11月7日

PUE=〔100kW(サーバ)+0kW(他の空調機などの消費電力)〕÷100kW(サーバ)=1.0

と示されるように、現実的には空調機はもとより、1台のモーターも回せないほどの厳しい数値であり、現実にはありえないほどの目標設定なのである。

前述したように、「けいはんなデータセンター」実証ではPUE=1.1と相当ハイレベルのデータセンターが実現されているが、このときの消費電力をさらに9%削減する●印のPUE=1.0がゴールである。この数値は乾いたタオルをさらに絞るほどの難しさである注10。

〔2〕PUE=1.0を実現する3つの背景

日本においては、マイクロソフトやグーグルのような豊富な資金力が求められる100万台規模の超大型データセンターというよりも、電力使用効率の高い中小規模のデータセンターの実現へのニーズが高いため、これに焦点を当てて次のように課題を解決していく方針である。

(1)今回のプロジェクトは、データセンター市場の多くを占める銀行や大規模な病院、自動車会社などがもつプライベートクラウドやエッジコンピューティングセンターなど中小規模のデータセンター(サーバ収容数:100〜1,000台)にフォーカスして、電力使用効率を向上させ、「PUE=1.1の壁」を突き破る。

(2)一般のデータセンターでは、発熱密度が高い部分と低い部分とが混在しているため、1つの冷却方式による冷却では効率が上がらない。そこで、発熱密度に応じた冷却方式を採用して対処する。具体的には、高発熱密度の例として、ビッグデータを処理するための高速演算処理(HPC:High Performance Computing)などを行うサーバの領域がある。これに対して、低発熱密度の例としては、事務系プライベートクラウドやHDD(ハードディスクドライブ)だけのラック(機器を収納する棚)などの領域がある。このうち低発熱密度部分は、電力消費が大きい大規模な送風機を使用する空調は不要であるため、抜本的な低消費電力向けの冷却技術を開発する必要がある。

(3)データセンターの信頼性として、現状では停電や故障に対応するため、空調を2重化(Redundancy)することが必須となっているが、2重化すると待機電力による電力消費や設備コストが大きくなる。このため、停電や故障時でも空調の2重化が不要な自立冷却技術を開発する必要がある。

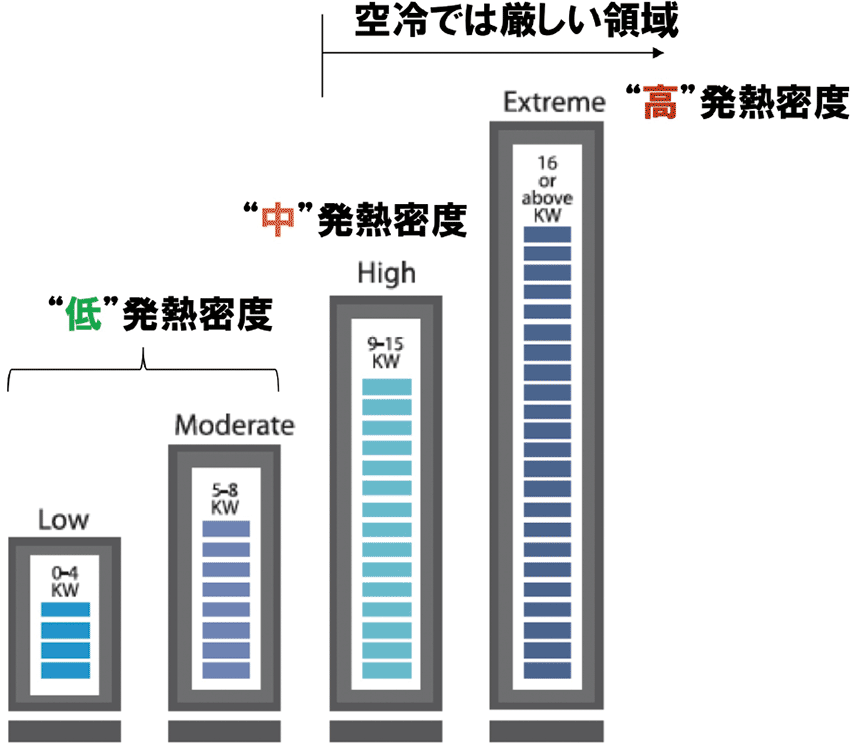

図4 データセンター内のラック当たり熱密度の分類

出所 環境省・平成28年度CO2排出削減対策強化誘導型技術開発・実証事業「データセンタの抜本的低炭素化」、2016年11月7日(NTTコミュニケーションズの“NTT whitepaperから引用“)

〔3〕今回の事業の方針

以上のような市場における強いニーズをベースに、今回のプロジェクトのターゲットに対して、次のような方針で取り組む。

(1)中小規模(サーバが100〜1,000台程度)のビル型データセンターを対象とする。

(2)停電や冷却機器が故障しても3時間以上は自立的に冷却ができるようにする。

(3)PUE=1.0 を目標とし、その実現のための抜本的省エネ(補機動力注11ゼロ化)によって「PUE=1.1の壁」を打破する。

(4)発熱密度に応じた冷却方式(負荷レベル別冷却方式)をゾーン(領域)ごとに適用する。かつこれにコストをかけない世界初の方法で実現する。

上記の方針を基に作成した、データセンター内のラック当たりの熱密度の分類を、図4に示す。データセンター内のラックには、次に示すような4種類のラックがある。

(1)「高」発熱密度(Extreme)ラック:16kW以上のラック

(2)「中」発熱密度(High)ラック:9〜15kWのラック

(3)「低」発熱密度2種類(Low、Moderate)のラック:0〜4kWのラック、5〜8kWのラック

このうち「中」発熱密度(9kW)以上のラックは空冷では難しいので直接液冷方式とする。今回の実証実験で使用している各サーバには、インテルのサーバ向け高機能CPU「Zeon」(ジーオン)が2個使用されているが、このCPUは1個で140W以上も電力を消費するため、発熱密度が高くなっている(最近のCPUは消費電力と性能が比例する傾向にある)。

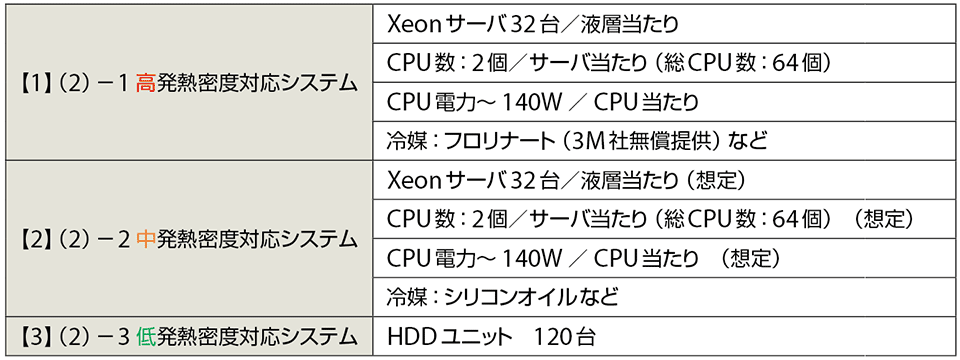

表2に、今回のプロジェクトで稼働している各発熱密度に対応したシステムの仕様を示す。

表2 今回のプロジェクトで稼働している各システムの仕様

"出所 環境省・平成28年度CO2排出削減対策強化誘導型技術開発・実証事業「データセンタの抜本的低炭素化」、2016年11月7日

▼ 注10

9%の根拠:PUE=1.1から1.0にするには、PUE=1.1(全体の電力)/1.0からPUE=1.0/1.0にしなければならないので、全体電力としては9%削減(1/1.1)になる。

▼ 注11

補機動力:冷媒を循環させるファンやポンプの電力など。