次世代AIインフラのためのGPUクラウド基盤ソフトウェア「Infrinia AI Cloud OS」

― ソフトバンクがAIデータセンター向けに開発 ―2026年1月29日 (木曜) 15:54

ソフトバンク株式会社(本社:東京都港区。以下、ソフトバンク)が、AIデータセンター向けのソフトウェアスタック「Infrinia AI Cloud OS」(Infrinia:インフリニア)の開発を、2026年1月21日に発表した。

ソフトウェアスタックとは、システムやアプリケーションの構築・運用に必要な複数のソフトウェアや機能を組み合わせて提供するものであるが、「Infrinia AI Cloud OS」により、GPUやKubernetes注1、AIワークロードの大規模な管理が可能となる。

なぜ「Infrinia AI Cloud OS」の開発に至ったのか

GPUを活用したAI処理の需要注2は急速に拡大し、これに伴ってAI処理におけるユーザーの用途や利用形態も多様化・高度化しているため、以下のニーズが発生している。

(1)GPUベアメタルサーバ注3が抽象化され、GPUクラウドサービス事業者で管理されているインフラの利用

(2)コスト最適化を実現し、GPUを意識せず利用できる、高度に抽象化された推論サービスの活用

(3)AIモデルを中央サーバで学習させて最適化し、エッジAIで推論を行う高度な運用

一方で、上記のようなニーズに対応したGPUクラウドサービスの構築・運用には、高度な専門知識と煩雑な作業が必要なため、事業者には大きな負担となっている。

ソフトバンクの子会社であるSB Telecom America Corp. 内に設けられたInfriniaチーム(米国カリフォルニア州サニーベールを拠点)は、これらの課題を解決するため、GPUの性能を最大限に引き出しつつ、高度な機能を備えたGPUクラウドサービスの構築および運用を簡便かつ迅速に実現できる、「Infrinia AI Cloud OS」を開発した。

「Infrinia AI Cloud OS」の主な特長は?

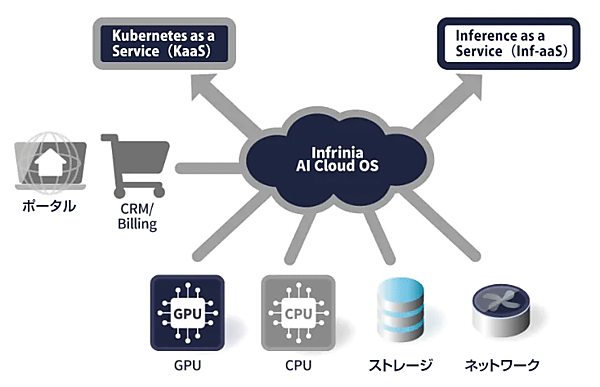

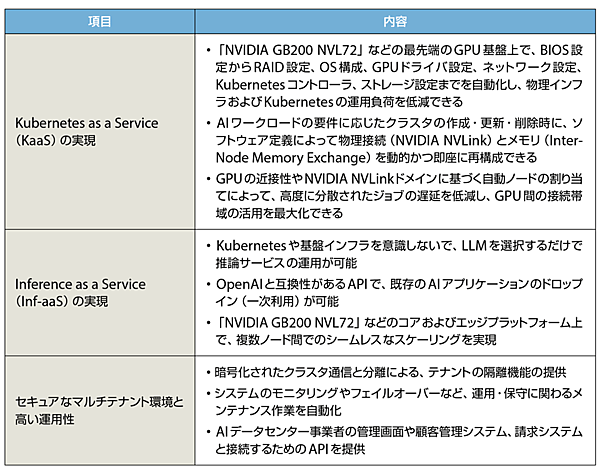

「Infrinia AI Cloud OS」特長は、主に「Kubernetes as a Service(KaaS)の実現」「Inference as a Service(Inf-aaS)の実現」「セキュアなマルチテナント環境と高い運用性」が挙げられる(図、表を参照)。

図 「Infrinia AI Cloud OS」の主な特長

出所 https://www.softbank.jp/corp/news/press/sbkk/2026/20260121_01/ をもとに一部加筆・日本語化して作成

表 「Infrinia AI Cloud OS」の主な特長

NVIDIA GB200 NVL72:72個のBlackwell GPU、36個のGrace CPUを1ラックに搭載し、液冷技術を採用したNVIDIAの最新の超高性能AIコンピューティングシステムソリューション。

BIOS:Basic Input Output System

RAID:Redundant Array of Inexpensive Disks

クラスタ:Cluster。複数のコンピュータやサーバをネットワーク接続し、全体を1台のシステムのように機能させる技術(クラスタシステム)。

OpenAI:AIの研究と開発を行う米国企業(米国・サンフランシスコ)が提供している最先端のAIモデル。最も有名なものはGPT(Generative Pre-trained Transformer)シリーズ。

フェイルオーバー:稼働中のシステムやサーバに障害が発生した際に、予備システムに動作を自動切り替えすること。

出所 https://www.softbank.jp/corp/news/press/sbkk/2026/20260121_01/ をもとに一部加筆・修正して作成

「Infrinia AI Cloud OS」を導入することで、AIデータセンター事業者やGPUクラウドサービスを展開する企業などは、複数のユーザーが同一のサーバやアプリケーションを共有利用できるマルチテナント環境に対応した「Kubernetes as a Service」(KaaS)と、大規模言語モデル(LLM)の推論機能をAPI(Application Programming Interface)として提供する「Inference as a Service」(Inf-aaS)を、自社のGPU(Graphics Processing Unit)クラウドサービスの機能として構築することが可能となる。

これによって、TCO(Total Cost of Ownership、総所有コスト)や運用負荷の低減が期待できるようになるため、AIデータセンター事業者は、AIモデルの学習から推論までを効率的かつ柔軟に行えるGPUクラウドサービスを、迅速に提供することが可能となる。

ソフトバンクは今後、自社のGPUクラウドサービスへ「Infrinia AI Cloud OS」を導入する予定で、AIエージェント、フィジカルAIへと進化を続けるAIの活用をさらに深めるため、社会実装する必要な機能として、新たなGPUクラウドサービスおよびソフトウェア事業を開始する。

注1:Kubernetes:クバネティス。アプリケーションのデプロイやスケーリングを自動化したり、コンテナ化されたアプリケーションを管理したりするためのオープンソースソフトウェア(OSS)。Kubernetesの利用によって一括で自動管理することが可能となるため、システム開発や管理が大幅に効率化できる。

・デプロイ:Deploy。開発したテスト済みのWebアプリケーションやシステムを、実際のWebサーバ上に配置して利用可能な状態にすること。

・スケーリング:Scaling。ユーザー数やデータ量の増大など、需要の変化に応じてシステムやアプリケーションの処理能力や容量を拡大・縮小したりして、パフォーマンスを安定させ維持すること。

・コンテナ:container。アプリケーションの実行に必要な環境をパッケージ化(統一化)し、異なる環境でも同様な動作を可能とする仮想化技術。

注2:例えば生成AIやロボティクス、シミュレーション、創薬、材料開発など。

注3:GPUベアメタルサーバ:GPU Bare Metal Server。OSやソフトウェアなどがインストールされていない、物理的なGPU搭載サーバのこと。

バックナンバー

関連記事

AIが変える通信ネットワークの未来

1月20日 17:03

AI-RAN統合ソリューション「AITRAS」、開発とそのロードマップ

2025年3月12日 0:00

ソフトバンク先端技術研究所 所長 湧川隆次氏に聞く! 「AI-RANアライアンス」で6G革命を推進し、ビジネスを変革する!

2024年5月17日 0:00

【第3回】米国のエネルギー政策②:エネルギー技術への連邦政府の支援を再定義したOBBBA(包括的な税制・歳出改革法)と関税政策

1月16日 11:29

「ワット・ビット連携」技術の標準化がITU-Tで合意!

2025年11月25日 12:00

電力・ガス全面自由化に向けたティージー情報ネットワークの基盤改革

2016年3月6日 0:00

筆者の人気記事

5Gセキュリティの最新動向<その1>3GPPにおける5Gセキュリティの標準化動向

2019年9月11日 0:00

日本でも2030年代の導入目指しBeyond 5G(6G)の戦略的検討が始まる

2020年2月3日 0:00

5Gセキュリティの最新動向<その2>ITU-T SG17における5Gセキュリティの展開

2019年9月11日 0:00

エネルギーIoTで変革をめざすNTTスマイルエナジーの再エネアグリゲータとしての挑戦

2018年1月1日 0:00

中部電力が「電柱×ICT機器×LPWA」で新IoTサービスの実証実験を開始!

2017年6月14日 0:00

中国電力グループが「自立電源設置サービス」を開始!

2019年12月12日 0:00